信息论笔记·信道和编码

离散信道及其容量

信道的分类

根据信道的输入输出特性,可以分为:

- 离散信道:输入输出空间都是离散的

- 连续信道:输入输出空间都是连续的

- 半连续信道:输入输出空间中一个是离散的,而另一个是连续的

- 波形信道:输入输出都是时间的实函数

根据信道的统计特性,可以分为:

- 恒参信道:统计特性不随时间变化

- 变参信道:统计特性随时间变化

根据信道的记忆特性,可以分为:

- 无记忆信道:信道输出仅仅和当前的输入有关

- 有记忆信道:信道的输出还和过去的输入有关

还有几种比较特殊的信道:

满足以下条件之一(其实三个条件等价)的信道称为无损信道,无损信道的输出完全由输入决定:

- 总存在输出符号集合

- 对于所有的输入分布,只要

- 对于所有的输入分布,已知

满足以下条件之一(其实两个条件等价)的信道称为无噪信道,无噪信道中不存在随机干扰:

- 对于所有的

既无损又无噪的信道叫做确定信道。

离散无记忆信道

首先来讨论单符号离散信道。假设信道输入随机变量(总体)为

接下来介绍几个后面常用的名词,以免产生困扰:

先验概率:指的是信源的统计特性,即:

前向概率:即信道传递概率,也就是上面那个矩阵里面的元素,表示已经收到信源为

输出符号概率:指的是输出的统计特性,即:

后向概率:指的是目前已经知道输出是

联合概率:指的是输入为

定义“信道疑义度”(损失熵)为:

无记忆扩展信道

对于单符号无记忆信道来说,输入和输出的都是一个符号。如果一个信道的输入是单符号信道的信源的N次扩展(也就是长度为N的序列),输出是单符号信道信宿的N次扩展,那么这个信道就是单符号信道的N次扩展信道。

在一般的信道中,传输长度为N的信息,有如下的定理:

如果输入和输出是

如果输入和输出是

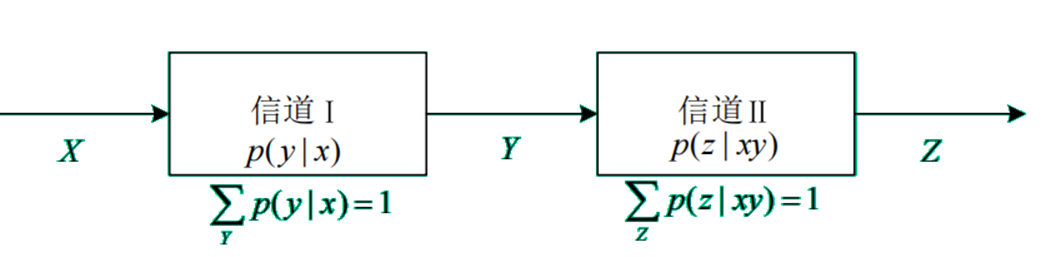

信道的组合

级联信道的模型如下:

对于级联信道中的互信息,有:

级联信道中的平均互信息满足:

把上面两式右边的

如果

也就是说,在任意信息传输系统中,最后获得的信息至多是信源提供的信息,如果在传输过程中丢失了信息,而且以后的系统不触及输入端,那么丢失的信息就不能再恢复。

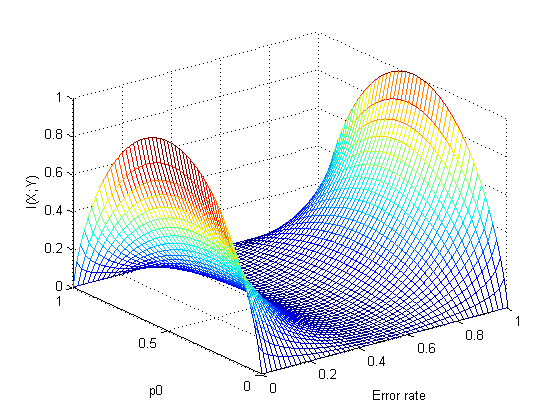

信道容量

对一个特定的信道而言,其信道容量是平均互信息量随输入符号集变化时的最大值:

离散无噪信道

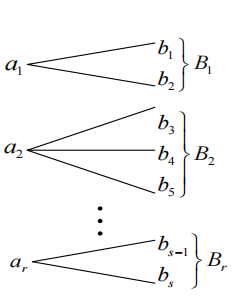

无损信道

无损信道的一个输入对应多个不相交的输出,输出端接收到

一个典型的无损信道矩阵如下:

其信道疑义度(损失熵)

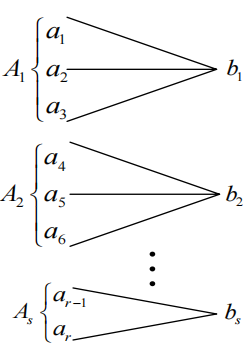

确定信道

确定信道是一个输出对应多个互不相交的输入的信道,即发出信源

一个典型的确定信道矩阵如下:

其噪声熵

其信道容量为:

无损确定信道

既无损又确定的信道是无损确定信道。其矩阵是单位阵,输入输出之间有一一对应关系。

离散对称信道

若一个离散无记忆信道的信道矩阵中,每一行都是其它行的同一组元素的不同排列,则称此类信道为离散输入对称信道,一个典型的离散输入对称信道矩阵为:

如果一个离散对称信道有

达到信道容量

对于离散无记忆

无失真信源编码

将信源产生的全部信息无损地送给信宿,这种信源编码称无失真信源编码。编码可以分为:

- 定长码:所有码字长度相等的码

- 变长码:码字长度可能不相等的码

或者

- 奇异码:码组中有相同的码字

- 非奇异码:码组中没有相同的码字

分组码

分组码指的是把信源符号集中的每一个符号

设信源符号

分组码能正确译码的必要条件是非奇异,这很直观,但是并不是充分的。

如果一个分组码对于任意的正整数

虽然都是唯一可译码,但是译码方式仍有不同。考虑以下两种码:

| 符号 | 码1 | 码2 |

|---|---|---|

| 1 | 1 | 1 |

| 2 | 10 | 01 |

| 3 | 100 | 001 |

| 4 | 1000 | 0001 |

对于码1来说,我接收到一个消息,比如10,此时我并不知道符号是2、3还是4。直到下一个符号到达,我接收到的消息变成101...,我才知道前面的符号是2。但是对于码2,当我接收到01时,我立刻就能知道这个符号是2。

把像码2这种接收到一个码字就能立刻译码的唯一可译码称为“即时码”。一个唯一可译码是即时码的充要条件是其中任何一个码都不是其它码的前缀。

定长码

唯一可译定长码

对于有

定长信源编码定理

引理:设离散无记忆信源的熵为

也就是说,当

对于定长编码,定义编码速率:

【例】现有离散无记忆信源:

对其采取等长二元编码,编码效率 ,允许错误概率不大于 ,求 最少是多少 【解】信源信息熵为

自信息量的方差为: 则

变长码

变长码无需很长的码长就能实现高效率的无失真信源编码。关于信源符号数、码字长度之间应该满足什么条件,才能构成唯一可译码,有:

设信源符号集为

如果把上面的定理中的“唯一可译即时码”换成“唯一可译码”,其它都不变,定理仍然成立。

变长编码定理

如果传输一个码符号需要

对于固定的信源和码符号集,如果有一种唯一可译码的平均码长小于所有其它唯一可译码,则称其为紧致码。

对于离散无记忆信源

变长码的编码方法

香农编码

香农编码的编码方式如下:

把信源发出的

按下式计算第

计算第

把累加概率转换成二进制小数,并截取小数点后的前

【例】对以下信源进行香农编码

消息 s1 s2 s3 s4 s5 s6 s7 概率 0.2 0.19 0.18 0.17 0.15 0.1 0.01 【解】香农编码表如下:

消息序号 消息概率 累加概率 码组长度 二进制代码 s1 0.2 0 2.3 3 000 s2 0.19 0.2 2.4 3 001 s3 0.18 0.39 2.4 3 011 s4 0.17 0.57 2.5 3 100 s5 0.15 0.74 2.7 3 101 s6 0.1 0.89 3.3 4 1110 s7 0.01 0.99 6.6 7 1111110

霍夫曼编码

霍夫曼编码是一种紧致码,它的编码过程为:

- 把

- 用

0,1分别代表概率最小的两个信源,把这两个符号合并成一个新符号,从而得到包含 - 把缩减信源的符号概率仍从大到小排序

- 重复2~3,直到信源只剩下两个符号为止,把这最后两个符号用

0和1表示,然后从最后一级缩减信源开始向前返回,得到编码。

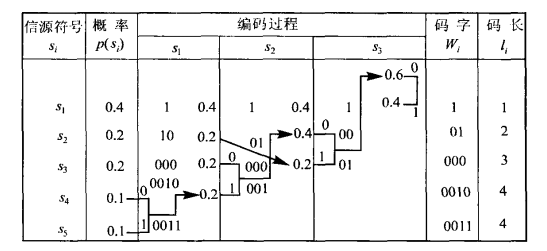

【例】对以下信源进行霍夫曼编码:

符号 s1 s2 s3 s4 s5 概率 0.4 0.2 0.2 0.1 0.1 【解】

费诺码

费诺码的编码过程如下:

- 把

- 把依次排列的信源符号依概率分为两大组,使两个组的概率和尽可能相等,然后给各组赋予一个二进制码符号

0和1 - 把上面这两大组中每一大组的符号再分成两部分,使得划分后两小组的概率和尽可能相等,然后给各组赋予一个二进制码符号

0和1 - 重复2~3,直到每个组都只剩下一个符号为止

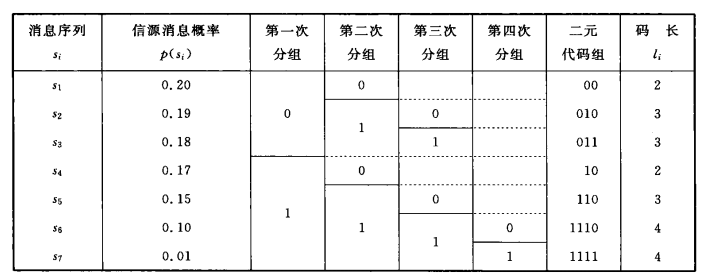

【例】对以下信源进行费诺编码

符号 s1 s2 s3 s4 s5 s6 s7 概率 0.2 0.19 0.18 0.17 0.15 0.1 0.01 【解】

平均码长为

信息速率

本站的运行成本约为每个月5元人民币,如果您觉得本站有用,欢迎打赏: